Experimentos y apuestas

En la novena sesión del programa de dirección de producto del Instituto Tramontana nos enfrentamos a una de las verdades más incómodas del oficio: la mayoría de nuestras ideas no funcionan. No algunas. La mayoría.

Los datos de las principales empresas tecnológicas son reveladores. En Microsoft, solo un tercio de las ideas testeadas mejoran las métricas para las que fueron diseñadas. En Bing y Google, dominios bien optimizados, la tasa de éxito es del 10-20%. Netflix considera que el 90% de lo que prueban resulta estar equivocado. Slack reporta que solo el 30% de los experimentos de monetización muestran resultados positivos.

Aceptar esta realidad no debería paralizarnos. Debería liberarnos. Si el fracaso es la norma, el objetivo no es evitarlo sino aprender rápido de él.

Los orígenes de la experimentación controlada

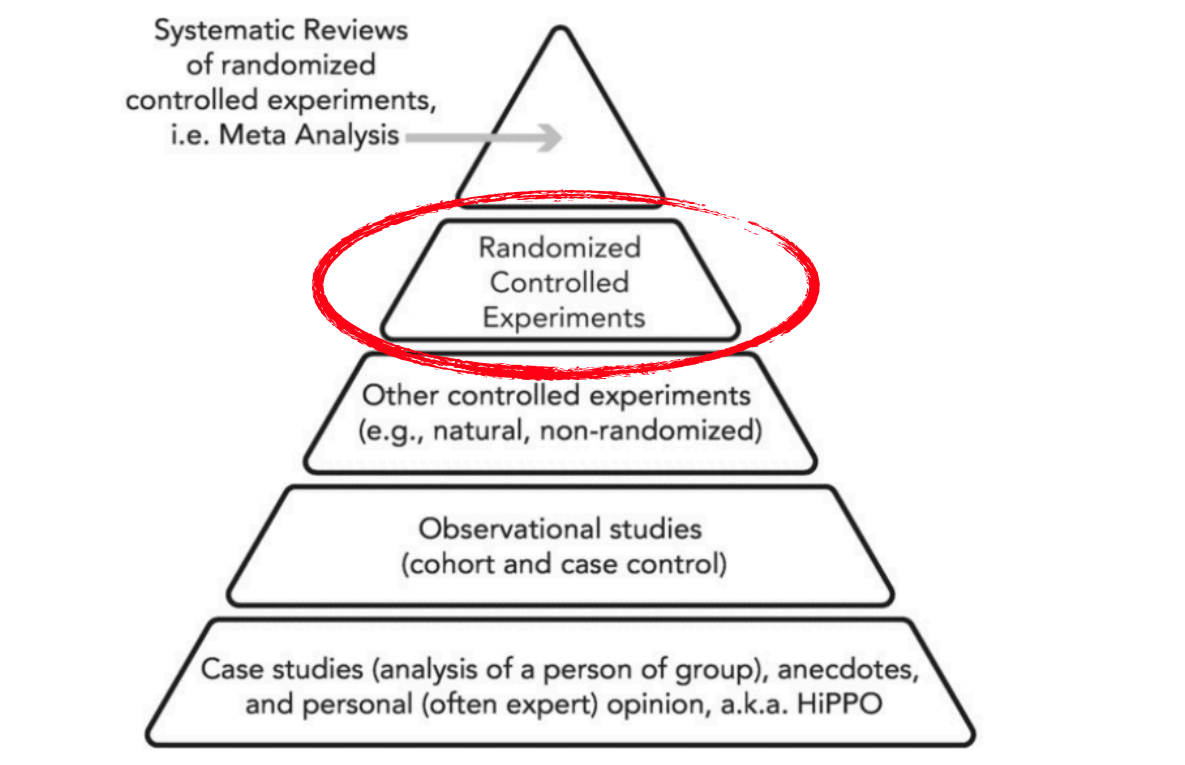

La experimentación controlada tiene sus raíces en la medicina. En 1995, Guyatt popularizó la jerarquía de evidencia como forma de graduar las recomendaciones médicas. Esta jerarquía sitúa a los experimentos controlados aleatorios (RCTs) como el estándar de oro para establecer causalidad. No opiniones. No correlaciones. Causalidad.

En la base están las opiniones de expertos y los casos anecdóticos —lo que en el mundo de producto digital se conoce como HiPPO (Highest Paid Person's Opinion). Subiendo por la pirámide encontramos estudios observacionales, experimentos no aleatorizados, y finalmente, en la cúspide, los experimentos controlados aleatorios y sus metaanálisis.

Esta aproximación rigurosa se ha trasladado al mundo digital a través del A/B testing y otras técnicas de experimentación. El libro de referencia fundamental es Trustworthy Online Controlled Experiments de Ron Kohavi, Diane Tang y Ya Xu. Kohavi, que lideró la experimentación en Microsoft y Airbnb, documenta con rigor cómo las empresas tecnológicas han adoptado —y adaptado— los principios de la medicina basada en evidencia.

Pero la experimentación en producto digital tiene particularidades. A diferencia de los ensayos clínicos, podemos iterar rápido. Podemos fallar barato. Podemos aprender en ciclos cortos. Esta velocidad es una ventaja competitiva si sabemos aprovecharla.

Decisiones y resultados: dos cosas distintas

Un concepto fundamental de esta sesión es separar la calidad de la decisión de los resultados obtenidos. Son dos cosas distintas, aunque tendemos a confundirlas.

Imagina un diagrama con dos círculos. Uno pequeño representa la decisión: lo que controlamos, la información que tenemos, el análisis que hacemos. Otro círculo, mucho más grande, representa todo lo demás: lo que no sabemos y la suerte. El resultado final emerge de la interacción de ambos.

Las implicaciones son importantes:

- Una buena decisión puede llevar a un mal resultado. Mala suerte.

- Una mala decisión puede llevar a un buen resultado. Buena suerte.

- Juzgar la calidad de una decisión por su resultado es un error lógico.

Annie Duke, exjugadora profesional de póker y autora de Thinking in Bets, lo expresa bien: debemos evaluar el proceso de decisión, no solo el resultado. Un jugador de póker puede hacer la jugada correcta y perder la mano. Eso no significa que la jugada fuera incorrecta.

El ciclo de aprendizaje

Proponemos un modelo cíclico para gestionar la incertidumbre:

Apuesta → Resultado → Aprendizaje → Reducción de incertidumbre → Nueva apuesta

Cada vuelta del ciclo nos hace más sabios. No porque acertemos más —recordemos que la mayoría de las ideas fracasan—, sino porque reducimos el espacio de lo desconocido. Cada experimento, funcione o no, nos da información que no teníamos antes.

Este modelo tiene consecuencias prácticas:

- No hay experimentos fallidos si aprendemos algo. El fracaso es un resultado, no un error.

- La velocidad del ciclo importa. Cuanto más rápido iteramos, más rápido aprendemos.

- La documentación es esencial. Si no registramos qué apostamos, qué observamos y qué aprendimos, perdemos el valor del experimento.

Calibrar la confianza

Antes de hacer una apuesta, debemos preguntarnos: ¿qué confianza tengo?

En cualquier equipo encontramos diferentes niveles de confianza ante una propuesta:

- "No lo sé"

- "Creo que sí"

- "¡Seguro!"

- "No lo veo"

La sobreconfianza lleva a no experimentar cuando deberíamos. Si estamos seguros de que algo funcionará, ¿para qué testearlo? Pero recordemos los datos: la mayoría de las ideas fracasan, incluso las que parecen obvias.

La infraconfianza lleva a parálisis por análisis. Si nunca estamos suficientemente seguros, nunca lanzamos nada.

El objetivo es calibrar nuestra confianza con la realidad. Ser humildes sobre lo que no sabemos, pero decididos a aprender mediante la acción.

¿Qué apostamos?

Una vez que entendemos nuestra confianza, la siguiente pregunta es: ¿qué apostamos?

Esto implica definir con claridad:

- Qué recursos invertimos. Tiempo, dinero, personas. Toda apuesta tiene un coste.

- Qué métricas mediremos. Sin métricas claras no hay experimento, solo opiniones.

- Cuánto tiempo daremos. Un experimento sin fecha de cierre no es un experimento.

- Qué decisión tomaremos según los resultados. Si A, haremos X. Si B, haremos Y. Definirlo antes evita el sesgo de interpretar los resultados a conveniencia.

Aquí conectamos directamente con lo que vimos en la sesión 7 sobre métricas. Las métricas de comportamiento y las métricas de dinero que aprendimos a construir son las que usamos para evaluar nuestros experimentos. Sin buenas métricas, no hay buena experimentación.

El tamaño de muestra importa

Un punto técnico pero crucial: para obtener resultados estadísticamente significativos, se necesita un tamaño de muestra adecuado. La regla general es más de 1.000 usuarios por variante para detectar efectos pequeños pero significativos.

Esto tiene implicaciones importantes:

- No todas las empresas pueden hacer A/B testing efectivo. Si no tienes suficiente tráfico, los resultados no serán confiables.

- Los efectos pequeños requieren muestras grandes. Si esperas una mejora del 1%, necesitas muchos más usuarios que si esperas una mejora del 50%.

- El tiempo del experimento depende del tráfico. Más tráfico = resultados más rápidos.

Para quienes no tienen volumen suficiente, hay alternativas: investigación cualitativa, pruebas con usuarios, análisis de cohortes. No son el estándar de oro de los RCTs, pero son mejores que no validar nada.

La trampa del estándar de oro

Aquí viene una advertencia que considero importante: la experimentación aleatorizada como estándar de oro no se puede trasladar alegremente al producto digital. A menudo se hace, y a menudo sale mal.

El problema es que la experimentación rigurosa exige recursos. Muchos. Diseñar bien un experimento, instrumentarlo correctamente, conseguir muestras significativas, analizar los resultados con rigor estadístico, documentar los aprendizajes... Todo eso cuesta tiempo y personas. Y mientras inviertes en esa maquinaria, puedes estar alejándote de lo que realmente importa: conocer a tus clientes, entender sus problemas, construir soluciones que funcionen.

He visto demasiadas veces cómo equipos de producto se introducen en una complejidad enorme —plataformas de experimentación, dashboards de métricas, procesos de validación— sin que luego eso se traduzca en mejores decisiones. Se convierte en un ejercicio de pinta y colorea: la forma está, pero la sustancia no.

La realidad es que la mayoría de lo que las empresas llaman "experimentos" no son experimentos en el sentido estricto. Son apuestas medidas. Hacemos algo, medimos qué pasa, y sacamos conclusiones. Eso está bien. Es útil. Pero no es un RCT. No establece causalidad con rigor. No controla las variables de confusión.

Y no pasa nada. Para la mayoría de las decisiones de producto, una apuesta medida es suficiente. Lo importante es ser honestos sobre lo que estamos haciendo. No llamar "experimento" a lo que es una observación. No atribuir causalidad a lo que es correlación. No invertir en maquinaria de experimentación que no vas a usar bien.

El cálculo de fuerzas importa. Antes de montar una infraestructura de experimentación, pregúntate: ¿tenemos el volumen necesario? ¿Tenemos las capacidades analíticas? ¿Tenemos la disciplina para ejecutar experimentos de verdad? Si la respuesta es no, quizás sea mejor invertir esos recursos en hablar con clientes, observar comportamientos, y tomar decisiones razonables con la información que tengas.

Sesgos: el enemigo silencioso

Los sesgos cognitivos afectan a todo el proceso de experimentación:

- Cómo diseñamos los experimentos. Tendemos a diseñar tests que confirmen lo que ya creemos.

- Cómo interpretamos los resultados. Buscamos explicaciones que encajen con nuestras expectativas.

- Qué decidimos hacer. Ignoramos resultados que no nos gustan.

El sesgo de confirmación es especialmente peligroso. Avinash Kaushik, evangelista de analítica digital, lo expresó con crudeza: "el 80% del tiempo estamos equivocados sobre lo que el cliente quiere". Pero rara vez nos sentimos equivocados. Nos sentimos seguros.

La experimentación rigurosa es, en parte, un mecanismo para protegernos de nosotros mismos. Definir las reglas antes de ver los resultados. Comprometernos con la acción antes de conocer el desenlace. Documentar para que otros puedan verificar.

Una cultura de experimentación honesta

La sesión terminó con una reflexión sobre qué significa realmente construir una cultura de experimentación. No es solo tener herramientas de A/B testing. Es aceptar que:

- La mayoría de nuestras ideas no funcionarán.

- No pasa nada. Es lo normal.

- El objetivo es aprender rápido, no tener razón.

- Una idea descartada tras un experimento bien hecho es un éxito, no un fracaso.

Fareed Mosavat, Director de Producto en Slack, lo resume bien: "Si estás en un equipo orientado a experimentación, acostúmbrate a que el 70% de tu trabajo sea descartado". Esto requiere un cambio mental profundo. Dejar de identificarnos con nuestras ideas. Ver los experimentos como preguntas, no como apuestas personales.

La experimentación no es una técnica. Es una actitud ante la incertidumbre.

Práctica de la sesión

Caso de uso: Diseño de un experimento real. Trabajamos sobre un escenario del repositorio del programa donde una organización quiere tomar una decisión basada en evidencia. El ejercicio consistía en diseñar el experimento completo: hipótesis, métricas, tamaño de muestra, duración, y reglas de decisión según los posibles resultados.

Para casa: Continuar con el ejercicio del repositorio, ahora trabajando con el dataset proporcionado. El objetivo era analizar los resultados de un experimento simulado, aplicar los conceptos de significancia estadística, y tomar una decisión fundamentada. Un ejercicio de pasar de los datos a las consecuencias.